従来、データセンターは空冷に依存してきました。機械式チラーが冷却された空気を循環させ、サーバーから熱を吸収することで、最適な状態を維持していたのです。しかし AI モデルの規模が大きくなり、AI リーズニング モデルの利用が増えるにつれ、最適な状態を維持することは困難になり、コストも高くなるだけでなく、エネルギー消費量も増加しています。

かつてデータセンターはラックあたり 20kW で稼働していました。しかし今日のハイパースケール施設では、ラックあたり 135kW を超える電力をサポートできるため、高密度ラックから発生する熱を放散することは桁違いに困難になっています。AI サーバーを最高のパフォーマンスで稼働させるには、効率性と拡張性を高めるための新たなアプローチが必要な状態となっています。

重要な解決策の一つが液冷です。チラーへの依存を減らし、より効率的な放熱を可能にする液冷は、次世代の高性能でエネルギー効率の高い AI インフラを推進しています。

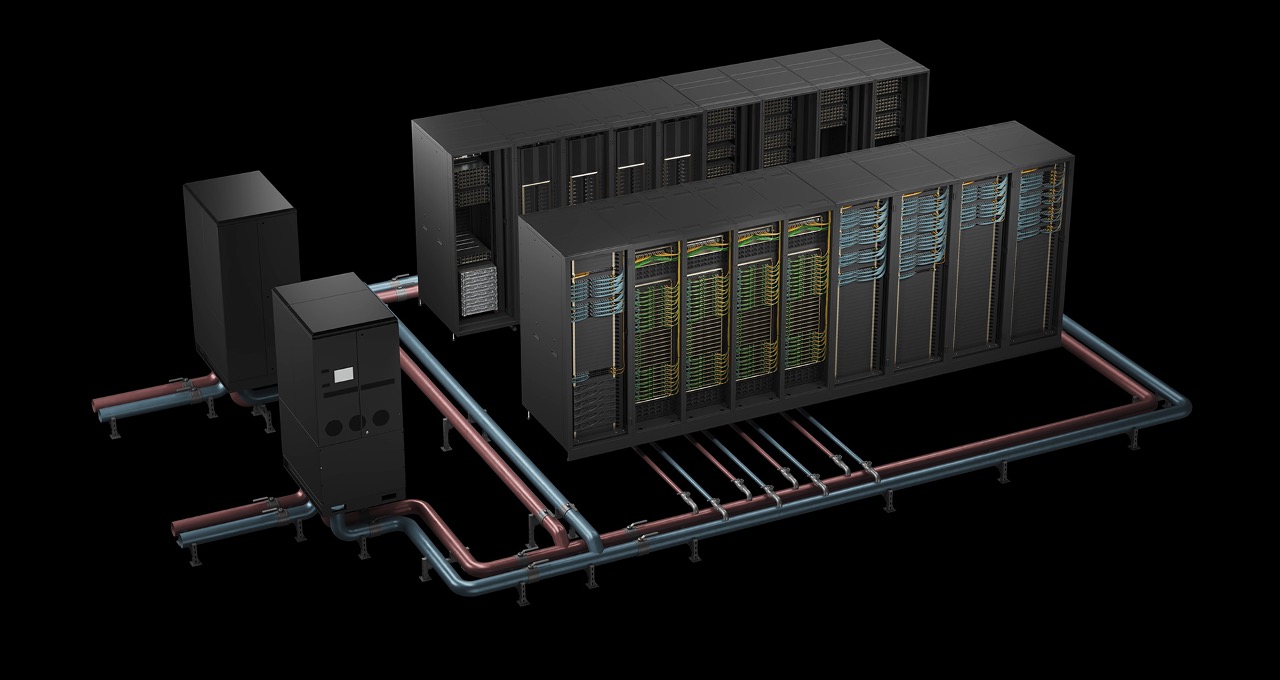

NVIDIA GB200 NVL72 と NVIDIA GB300 NVL72 は、ラックスケールの液冷システムで、数兆パラメータの大規模言語モデルの推論という要求の厳しいタスクに対応できるように設計されています。これらのアーキテクチャは、テストタイム スケーリングの精度とパフォーマンスにも最適化されており、エネルギー コストと熱を効率的に管理しながら AI リーズニング モデルを実行するための理想的な選択肢となっています。

AI データセンターにおける前例のない水の使用効率とコスト削減を実現

これまで、冷却だけでデータセンターの電力消費量の最大 40% を占めており、効率改善によって運用コストとエネルギー需要の両方を削減できる最も重要な領域の一つとなっています。

液冷は、熱源で直接熱を捕捉することで、コストとエネルギー消費量を削減します。空気を介さない直接チップ液冷方式は、技術冷却システムのループ内で熱を伝達します。伝達された熱は、液-液熱交換器を介して冷却剤分配ユニットを循環し、最終的に施設の冷却ループへと送られます。この熱移動の効率が高いため、データセンターや AI ファクトリーはより高温の水でも効率的に稼働でき、幅広い気候条件において機械式チラーの必要性を削減、あるいは排除することができます。

NVIDIA Blackwell プラットフォームを基盤とする NVIDIA GB200 NVL72 ラックスケール液冷システムは、エネルギーコストと熱のバランスを取りながら、卓越したパフォーマンスを提供します。各サーバーラックにかつてないほどのコンピューティング密度を凝縮し、従来の空冷アーキテクチャと比較して、収益性は 40 倍、スループットは 30 倍、エネルギー効率は 25 倍、水の使用効率は 300 倍向上します。Blackwell Ultra プラットフォーム上に構築された新しい NVIDIA GB300 NVL72 システムは、50 倍の収益の可能性、35 倍のスループット、30 倍のエネルギー効率を誇ります。

データセンターは、1 メガワット (MW) あたり年間約 190 万から 280 万ドルを費やしていると推定されており、これは冷却関連のエネルギーと水コストに年間約 50 万ドルを費やしていることになります。液冷式の GB200 NVL72 システムを導入することで、ハイパースケール データセンターや AI ファクトリーは、最大 25 分の 1 のコスト削減が実現可能となり、50MW のハイパースケール データセンターでは年間 400 万ドル以上のコスト削減につながります。

データセンターや AI ファクトリーの運営者にとって、これは運用コストの削減、エネルギー効率指標の向上、そして AI ワークロードを効率的に拡張できる将来を見据えたインフラを意味します。従来の冷却方法に伴う持続不可能なウォーター フットプリントの問題もありません。

データセンター外への熱の排出

コンピューティング密度が上昇し、AI ワークロードがかつてないほどの熱負荷を生み出す中、データセンターや AI ファクトリーはインフラから熱を排出する方法を見直す必要があります。予測可能な CPU ベースのスケーリングをサポートしてきた従来の熱除去方法は、もはやそれだけでは十分ではありません。現在、施設の外に熱を移動させる方法は複数ありますが、現在の展開および新しい展開では主に以下の 4 つのカテゴリが主流です。

変化する環境における主要な冷却方法

- 機械式チラー:機械式チラーは蒸気圧縮サイクルを利用して水を冷却し、データセンター内を循環させて熱を吸収します。これらのシステムは通常、空冷式または水冷式で、後者は熱を放出するために冷却塔と組み合わせられることがよくあります。チラーは様々な気候条件において信頼性が高く効果的ですが、エネルギー消費量も非常に多くなります。電力消費と持続可能性が最優先事項である AI 規模の施設では、チラーへの依存は運用コストと二酸化炭素排出量の両方に大きな影響を与える可能性があります。

- 蒸発冷却:蒸発冷却は、水の蒸発を利用して熱を吸収し除去します。これは、直接冷却システム、間接冷却システム、またはハイブリッド設計で実現できます。これらのシステムはチラーよりもはるかにエネルギー効率に優れていますが、水の消費量が多くなります。大規模な施設では、1 メガワットあたり年間数百万ガロンの水を消費することがあります。また、その性能は気候に左右されるため、湿度の高い地域や水資源が限られている地域では効果が低くなります。

- ドライクーラー:ドライクーラーは、自動車のラジエーターのように、大型のフィン付きコイルを用いて閉液ループから周囲の空気へ熱を移動させることで熱を除去します。このシステムは水を使用せず、水使用量の削減を目指す施設や乾燥した気候での運用に最適です。ただし、その効果は周囲の空気温度に大きく依存します。高温環境では、高温動作に耐えられる液冷式 IT システムと組み合わせない限り、高密度冷却の要求に対応できない可能性があります。

- ポンプ式冷媒システム:ポンプ式冷媒システムは、液体冷媒を使用してデータセンターから屋外の熱交換器へ熱を移動させます。チラーとは異なり、これらのシステムは施設内の大型コンプレッサーを必要とせず、水を使用しないで動作します。この方法は、熱力学的に効率的で、コンパクトかつ拡張性に優れたソリューションであり、特にエッジ展開や水資源が限られた環境に適しています。冷媒の適切な取り扱いと監視が必要ですが、電力と水の節約によるメリットは大きいです。

これらの方法はそれぞれ、気候、ラック密度、施設設計、持続可能性目標などの要因に応じて異なる利点を提供します。液冷が普及し、サーバーがより温水で動作するように設計されるようになると、より効率的で環境に優しい冷却戦略への道が開かれ、エネルギーと水の使用量を削減しながら、より高いコンピューティング性能を実現できるようになります。

AI インフラ向けデータセンターの最適化

AI ワークロードが飛躍的に増加するにつれ、運用事業者は高性能 AI とエネルギー効率に特化したインフラを構築することで、データセンター設計を再構築しています。データセンター全体を専用の AI ファクトリーに変革する、あるいはモジュール式コンポーネントをアップグレードする場合でも、推論パフォーマンスを最適化することはコスト管理と運用効率にとって不可欠です。

最高のパフォーマンスを得るには、高い演算能力を持つ GPU だけでは不十分です。GPU 同士が超高速で通信できる必要があります。

NVIDIA NVLink は、通信速度を向上させ、GPU を大規模かつ緊密に統合されたプロセッシング ユニットとして動作させながら、フルラックで 120kW の電力密度で最高のパフォーマンスを実現します。この緊密で高速な通信は、今日の AI タスクにとって極めて重要です。データ転送にかかる時間を 1 秒短縮できれば、1 秒あたりのトークン数が増え、AI モデルの効率も向上します。

従来の空冷では、このような電力レベルでは対応が困難です。この状況に対応するには、データセンターの空気を氷点下まで冷却するか、強風に近い速度で流して熱を逃がす必要があり、高密度のラックを空冷だけで冷却することはますます非現実的になっています。

空気の約 1,000 倍の密度を持つ液冷システムは、優れた熱容量と熱伝導率により、優れた放熱効果を発揮します。高性能 GPU から効率的に熱を移動させることで、液冷システムは消費電力と騒音の大きい冷却ファンへの依存を軽減し、冷却オーバーヘッドではなく演算処理に多くの電力を割り当てることを可能にします。

液冷システムの実例

業界全体で、イノベーターは以下のように液冷システムを活用したエネルギー コストの削減、密度の向上、AI 効率の向上に取り組んでいます。

- Vertiv の NVIDIA GB200 NVL72 サーバー向けリファレンス アーキテクチャは、年間エネルギー消費量を 25% 削減し、ラック スペース要件を 75% 削減し、電力フットプリントを 30% 縮小します。

- Schneider Electric の液冷インフラは、ラックあたり最大 132kW をサポートし、GB200 NVL72 AI データセンターのエネルギー効率、拡張性、そして全体的なパフォーマンスを向上させます。

- CoolIT Systems の高密度 CHx2000 液-液冷却水分配ユニットは、5℃ のアプローチ温度で 2MW の冷却能力を提供し、GB300 NVL72の 導入において信頼性の高い熱管理を実現します。また、CoolIT Systems の特許取得済み Split-Flow テクノロジを搭載した OMNI All-Metal Coldplates は、圧力損失を低減しながら、4,000W を超える熱設計電力をターゲットとした冷却を実現します。

- Boyd の高度な液冷ソリューションは、同社の 20 年以上にわたるハイパフォーマンス コンピューティング業界の経験を活かし、冷却剤分配ユニット、液冷ループ、コールドプレートを組み合わせて、高密度 AI ワークロードのエネルギー効率とシステム信頼性をさらに最大化します。

クラウド サービス プロバイダーも、最先端の冷却、電力技術のイノベーションを導入しています。共同開発の液冷ソリューションを採用した次世代 AWS データセンターは、水の使用効率を維持しながら、コンピューティング能力を 12% 向上させつつ、エネルギー消費量を最大 46% 削減します。

未来の AI インフラの冷却

AI が計算規模の限界を押し広げ続ける中で、ムーアの法則後の時代における熱管理の課題に対処するには、冷却技術のイノベーションが不可欠となります。

NVIDIA は、COOLERCHIPS プログラムなどの取り組みを通じて、この変革を主導しています。これは、米国エネルギー省が支援する次世代冷却システムを備えたモジュラー型データセンターの開発プロジェクトであり、従来の空冷設計と比較してコストを少なくとも 5% 削減し、効率を 20% 向上させると予測されています。

今後、データセンターは AI の需要の高まりに対応するだけでなく、持続可能な方法で進化する必要があります。つまり、エネルギーと水の使用効率を最大化し、環境への影響を最小限に抑える必要があるのです。高密度アーキテクチャと高度な液冷を採用することで、業界はより効率的な AI を活用した未来への道を切り開いています。

NVIDIA GTC 2025 で発表された、データセンターのエネルギーと水の効率化に関する画期的なソリューションの詳細をご覧のうえ、NVIDIA Blackwell によってアクセラレーテッド コンピューティングがより効率的な未来をどのように推進するかについての理解を深めてください。