テクノロジ デモでは、RTX GPU があれば誰でもパーソナライズされた GPT チャットボットが活用可能に

チャットボットは、NVIDIA GPU ベースのクラウド サーバーによって駆動され、毎日世界中の何百万人もの人々によって利用されています。今、これらの画期的なツールが、NVIDIA RTX を搭載した Windows PC に登場し、ローカルで高速なカスタム生成 AI を実現します。

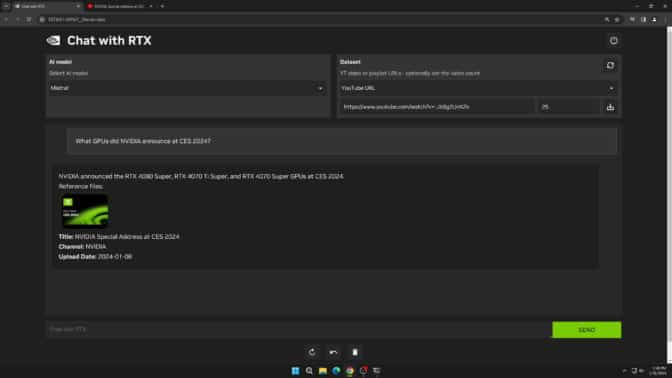

現在無料でダウンロードできる Chat with RTX は、ユーザーが独自のコンテンツでチャットボットをパーソナライズできるテクノロジ デモであり、8GB 以上のビデオメモリ (VRAM) を搭載した NVIDIA GeForce RTX 30 シリーズGPU またはそれ以上の GPU によって加速されます。

何でも聞いてみてください

Chat with RTX は、Retrieval Augmented Generation (RAG)、NVIDIA TensorRT-LLM ソフトウェア、および NVIDIA RTX アクセラレーションを使用して、生成 AI 機能を GeForce を搭載したローカルの Windows PC にもたらします。ユーザーは、PC 上のローカル ファイルをデータ セットとして、Mistral や Llama 2 のようなオープンソースの大規模言語モデルに迅速かつ簡単に接続することができ、文脈に関連した迅速な回答のための質問を可能にします。

メモや保存されたコンテンツを検索するのではなく、ユーザーは単に質問を入力することができます。例えば、「ラスベガスにいる間にパートナーが勧めてくれたレストランは?」と尋ねると、Chat with RTX はユーザーが提示したローカル ファイルをスキャンし、文脈に合わせて回答します。

このツールは、.txt、.pdf、.doc/.docx、.xml を含む様々なファイル形式をサポートしています。これらのファイルを含むフォルダをアプリケーションに指定すると、わずか数秒でそれらをライブラリに読み込みます。

また、YouTube のビデオやプレイリストからの情報を含めることもできます。Chat with RTX にビデオの URL を追加することで、ユーザーはこのナレッジをチャットボットに統合し、文脈に沿った質問を行うことができます。例えば、好きなインフルエンサーのビデオに基づいたおすすめの旅行を尋ねたり、主要な教育リソースに基づいた簡単なチュートリアルやハウツーを得たりできます。

Chat with RTX は Windows RTX PC およびワークステーション上でローカルに動作するため、提供される結果は高速で、ユーザーのデータはデバイス上に残ります。また、Chat with RTX は、クラウドベースの LLM サービスに依存するのではなく、ローカル PC 上で機密データを処理することができるため、ユーザーがデータを第三者と共有したり、インターネットに接続したりする必要はありません。

Chat with RTX には、最低 8GB の VRAM を搭載した GeForce RTX 30 シリーズ以上の GPU に加えて、Windows 10 または 11 と最新の NVIDIA GPU ドライバが必要です。

RTX で LLM ベースのアプリケーションを開発

Chat with RTX は、RTX GPU で LLM を加速する可能性を示しています。このアプリは、GitHub で公開されている TensorRT-LLM RAG 開発者リファレンス プロジェクトから構築されています。開発者は、このリファレンス プロジェクトを使用して、TensorRT-LLM で加速された RTX 向けの RAG ベースのアプリケーションを開発し、展開することができます。LLM ベースのアプリケーションの構築の詳細については、こちらをご覧ください。

2 月 23 日 (金) まで開催されている NVIDIA Gen AI on RTX PC 開発者コンテストに、生成 AI を搭載した Windows アプリまたはプラグインを応募すると、GeForce RTX 4090 GPU、NVIDIA GTC の現地参加パスなどの賞品を獲得できるチャンスがあります。

Chat with RTX についての詳細はこちらをご覧ください。

Chrome

Chrome Firefox

Firefox Opera

Opera Safari

Safari IE

IE